GRU 网络

LSTM 网络的计算成本很高,因此,研究人员发现了一种几乎同样有效的 RNN 配置,称为门控递归单元( GRU )架构。

在 GRU 中,不使用工作和长期记忆,只使用一种记忆,用 h(隐藏状态)表示。 GRU 单元通过复位和更新门将信息添加到此状态存储器或从该状态存储器中删除信息。

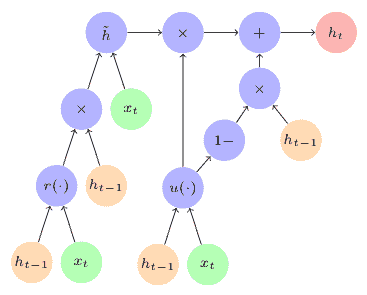

下图描绘了 GRU 单元(说明如下图):

The GRU Cell

The GRU Cell

GRU 单元中通过门的内部流量如下:

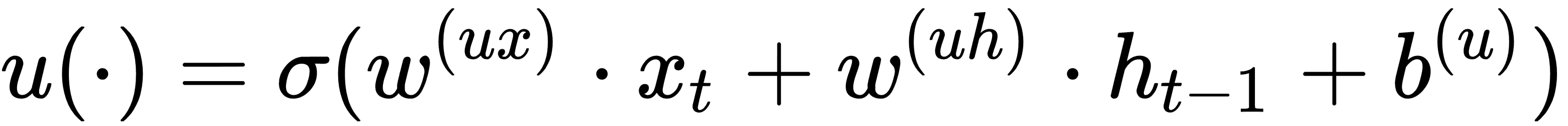

更新门

u():输入h[t-1]和x[t]按照以下公式流向u()门:

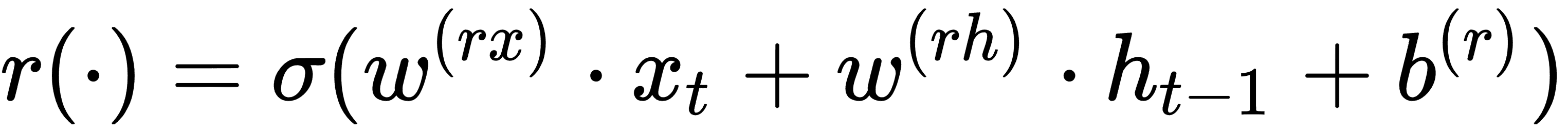

复位门

r():输入h[t-1]和x[t]按照以下公式流向r()门:

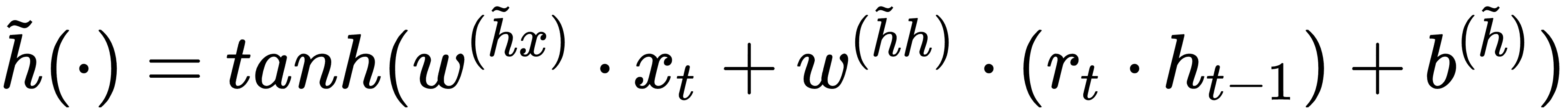

候选状态记忆:候选长期记忆是根据

r()门,h[t-1]和x[t]的输出计算出来的,按照下列公式:

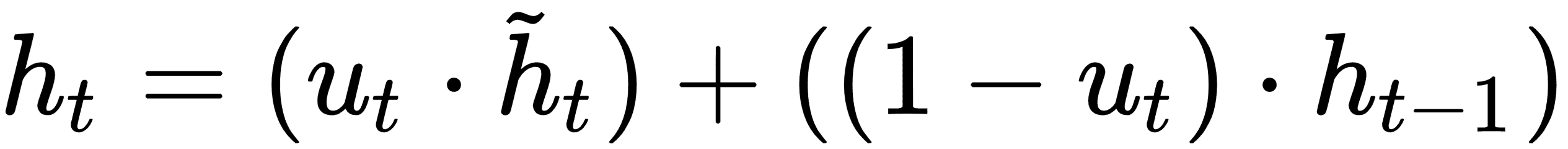

接下来,组合前面的三个计算以得到更新的状态存储器,由

h[t],表示,如下式所示:

阅读以下研究论文以探索 GRU 的更多细节:

K. Cho, B. van Merrienboer, C. Gulcehre, D. Bahdanau, F. Bougares, H. Schwenk, and Y. Bengio, Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation, 2014. https://arxiv.org/abs/1406.1078

J. Chung, C. Gulcehre, K. Cho, and Y. Bengio, Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling, pp. 1–9, 2014. https://arxiv.org/abs/1412.3555